IA: ¿algo nuevo o una tecnología de medio siglo?

De repente todo el mundo habla de IA.

En portadas, en anuncios de móviles, en herramientas de escritura, en apps para fotos… Si nos guiáramos por los medios, la inteligencia artificial “salió de la nada” en torno a 2022/2023.

Pero si rascamos un poco más, aparece una pregunta incómoda:

¿Es la IA realmente algo nuevo o una tecnología que lleva 50+ años aquí, solo que ahora se ha liberado “para la gente de a pie”?

¿Por qué parece que la IA explotó «de la noche a la mañana»?

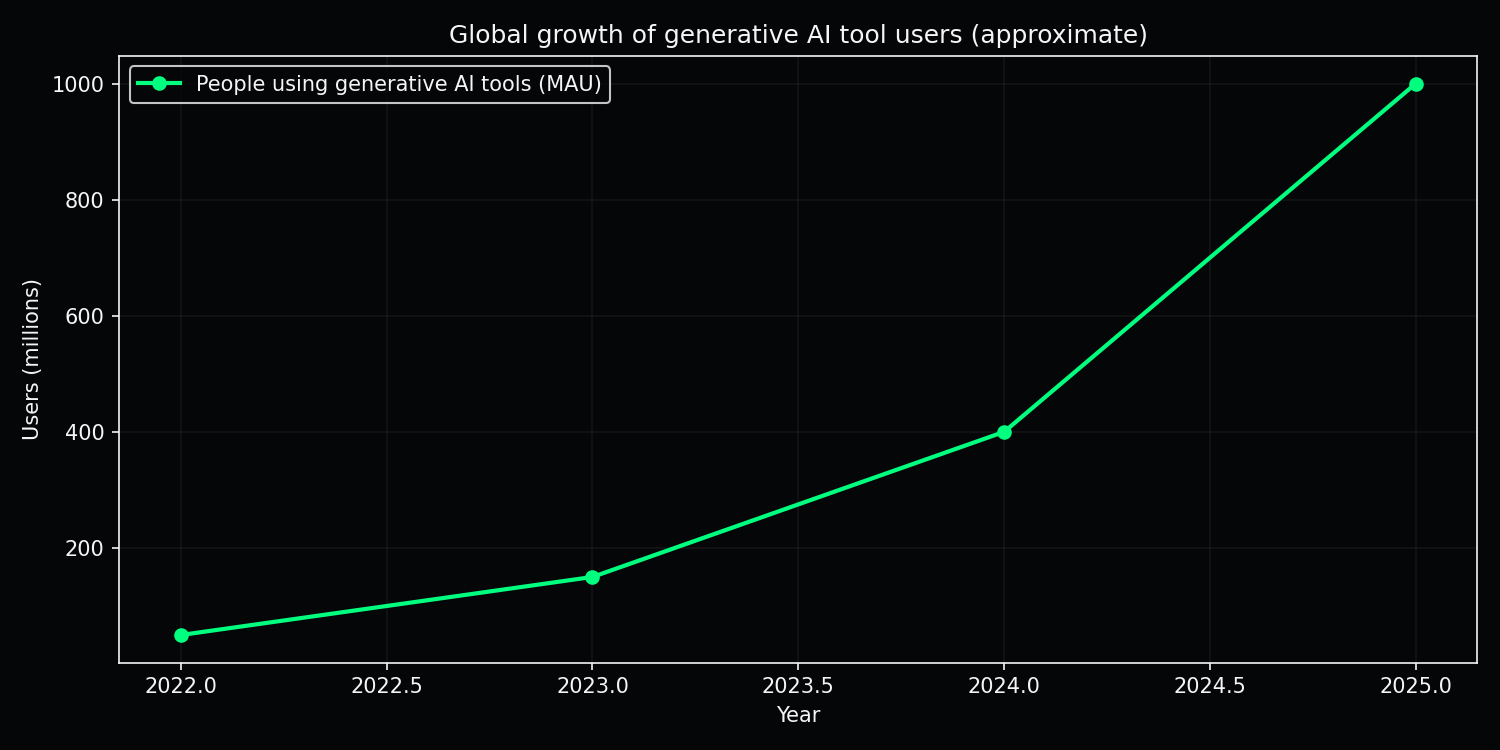

En solo unos años, el número de personas que usan herramientas de IA generativa pasó de un nicho de geeks a cientos de millones de usuarios. El gráfico lo deja claro:

Gráfico: crecimiento aproximado de usuarios activos mensuales de herramientas de IA generativa: de decenas de millones a alrededor de mil millones entre 2022 y 2025.

Desde la perspectiva del usuario medio, la historia se ve así:

- ayer no existía nada,

- hoy tenemos ChatGPT, generadores de imágenes, música, código, vídeo,

- mañana – quién sabe, quizá sistemas totalmente autónomos.

Sin embargo, bajo la superficie esta “explosión” es el resultado de una larga historia de desarrollo más varios hitos tecnológicos y de negocio.

Breve historia de la inteligencia artificial (sin libro de texto)

Años 50: Turing y la pregunta «¿pueden pensar las máquinas?»

Ya en 1950 Alan Turing plantea la famosa pregunta:

«¿Pueden pensar las máquinas?» y propone el test de Turing como criterio práctico.

La idea de inteligencia artificial en ese momento es más filosófica que práctica, pero la semilla queda plantada.

Años 60 y 70: IA simbólica y sistemas expertos

En las décadas siguientes domina la llamada IA simbólica:

- reglas del tipo “si–entonces” (IF–THEN),

- sistemas lógicos,

- primeros sistemas expertos que ayudaban, por ejemplo, a médicos en el diagnóstico.

Los ordenadores son lentos, los datos escasos, pero la ambición es enorme:

codificar el conocimiento directamente en el sistema mediante reglas.

Años 80: redes neuronales y backpropagation

En los años 80 vuelve el interés por las redes neuronales, modelos matemáticos inspirados en las neuronas del cerebro.

Momento clave: el método de backpropagation, que permite entrenar redes de forma mucho más eficiente.

Aun así, faltan:

- procesadores lo suficientemente potentes,

- conjuntos de datos masivos,

- e infraestructura informática “barata”.

Años 90 y 2000: data mining y primeros algoritmos de machine learning

Con la expansión de internet y las bases de datos, el foco se desplaza hacia:

- data mining – minería de datos,

- clasificación, regresión, recomendadores,

- primeros algoritmos de machine learning (SVM, random forest, boosting…).

La IA ya entonces trabaja en silencio en segundo plano:

en buscadores, recomendaciones de películas, filtros de spam, sistemas de scoring crediticio.

IA en el ejército y en proyectos «secretos»

Las tecnologías que hoy llamamos IA han vivido mucho tiempo a puerta cerrada:

- sistemas de radar y sonar,

- análisis de imágenes satelitales,

- reconocimiento automático de señales y cifrado,

- primeras formas de reconocimiento de voz e imagen.

La lógica es sencilla:

- si una tecnología da ventaja estratégica,

- primero la usan ejército y servicios de inteligencia,

- y solo después llega al sector civil.

Eso no significa que exista una sola “supermente secreta”, pero es realista suponer que:

- los experimentos con drones autónomos,

- sistemas de analítica masiva de datos

- y modelos avanzados de predicción

empezaron mucho antes de que viéramos los primeros chatbots públicos.

¿Por qué la «explosión» ha llegado justo ahora?

Tres razones principales por las que solo en los años 2020 hemos visto una IA masiva y visible:

1. La revolución de las GPU

Las tarjetas gráficas (GPU) creadas para juegos resultaron perfectas para:

- cálculos en paralelo,

- entrenar grandes redes neuronales.

Con la llegada de las plataformas en la nube (AWS, GCP, Azure), el acceso a esa potencia se vuelve alquilable: ya no hace falta tener tu propio centro de datos.

2. Big data: internet como gigantesco conjunto de datos

Internet ha proporcionado:

- miles de millones de frases de texto,

- miles de millones de imágenes, vídeos, fragmentos de código,

- registros infinitos del comportamiento de los usuarios.

Los modelos actuales se entrenan precisamente con esos datos.

3. El modelo de negocio

Solo ahora existe un claro incentivo empresarial:

- automatizar soporte y procesos,

- acelerar el desarrollo,

- nueva generación de herramientas SaaS,

- carrera entre los grandes actores (Big Tech) por cuota de mercado.

Resultado: la IA ya no se esconde “entre bastidores”, sino que se pone directamente en manos del usuario.

Cómo se diferencian los modelos generativos actuales de la «vieja» IA

Hoy hablamos sobre todo de IA generativa: modelos que escriben texto, dibujan imágenes, componen música y programan.

A alto nivel, la diferencia se ve así:

- Sistemas expertos (vieja IA) – reglas escritas a mano, lógica “si–entonces”, dominios muy acotados.

- LLM y deep learning (nueva IA) – aprenden de cantidades masivas de datos, detectan patrones estadísticos.

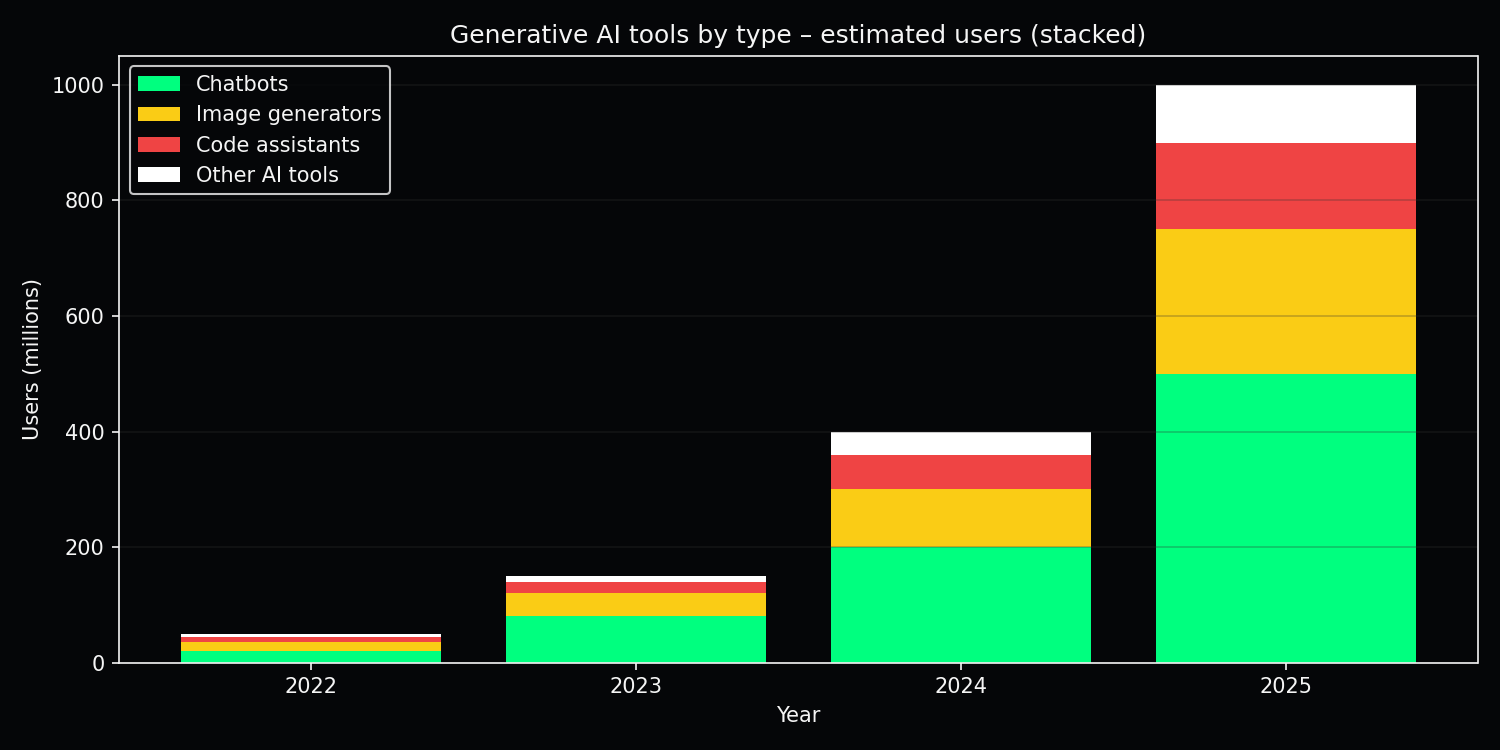

Una manera de visualizar dónde están los usuarios hoy es mirar los tipos de herramientas de IA que usan:

Gráfico: distribución aproximada de usuarios de herramientas de IA generativa por categoría: chatbots, generadores de imágenes, asistentes de código y otras herramientas de IA.

«Loros» que aun así hacen el trabajo

A menudo se dice que los LLM son solo «loros sofisticados»:

- no entienden el mundo como los humanos,

- predicen la siguiente palabra según la probabilidad.

Pero en la práctica:

- ese “loro” puede resumir cientos de páginas,

- estructurar información,

- escribir un primer borrador de texto, código o informe.

En otras palabras: puede que no sea un ser consciente, pero es una herramienta muy útil.

Qué probablemente ya existe entre bastidores

Si modelos tan potentes están disponibles públicamente, es razonable suponer que:

- existen versiones más grandes y especializadas para analítica,

- la IA ya se usa de forma masiva en análisis de inteligencia, mercados financieros, ciberseguridad,

- se están probando sistemas más autónomos de los que vemos en las apps de consumo.

El patrón histórico es parecido:

- la tecnología nace en laboratorios y proyectos especiales,

- se usa en silencio en segundo plano,

- y solo entonces llega al nivel de consumo como “algo nuevo”.

Riesgos y oportunidades

¿Qué puede ser positivo?

La cara positiva es importante:

- Medicina – análisis más rápido de imágenes, terapias personalizadas, detección de patrones en datos médicos.

- Ciencia – generación de hipótesis, análisis de sistemas complejos, aceleración de la investigación.

- Creatividad – herramientas para música, imágenes, vídeo, escritura; una sola persona con un portátil obtiene el poder de un pequeño estudio.

¿Qué puede salir mal?

También existen riesgos serios:

- Deepfakes y manipulación – cada vez es más difícil distinguir entre verdad y simulación.

- Vigilancia – la combinación de cámaras, reconocimiento facial y analítica crea nuevas formas de seguimiento.

- Automatización del trabajo – los empleos no “desaparecen de un día para otro”, pero sí se transforman, a menudo más rápido de lo que los sistemas educativos pueden adaptarse.

Tres escenarios breves

- Optimista – la IA se convierte en “copiloto” en el trabajo y en la vida diaria; la productividad aumenta, surgen nuevos tipos de empleos y la investigación médica se acelera.

- Pesimista – vigilancia, manipulación, concentración de poder en manos de unas pocas corporaciones y estados; las desigualdades sociales se profundizan.

- Mezcla realista – obtenemos ambas cosas; la IA se convierte en un espejo de la humanidad: refuerza tanto las tendencias buenas como las malas.

Conclusión: la IA como espejo, no como magia

La inteligencia artificial no es magia que “cayó del cielo” en 2022.

Es el resultado de décadas de trabajo en matemáticas, electrónica, software y, sobre todo, ambición humana.

La IA no solo cambia la tecnología; acelera lo que las personas ya son: creatividad y codicia, empatía y manipulación.

Por eso, la pregunta más importante para los próximos 10–20 años es menos técnica y más humana:

- no solo «¿qué puede hacer la IA?»,

- sino «¿qué queremos hacer nosotros con la IA?».

El hype y el miedo van y vienen, pero la responsabilidad se queda – con nosotros.